Introduction to Compressive Sensing in Wireless Communication

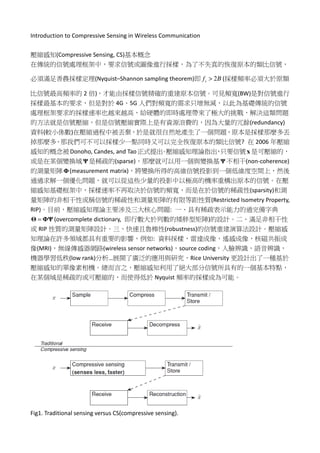

- 1. Introduction to Compressive Sensing in Wireless Communication 壓縮感知(Compressive Sensing, CS)基本概念 在傳統的信號處理框架中,要求信號或圖像進行採樣,為了不失真的恢復原本的類比信號, 必須滿足香農採樣定理(Nyquist–Shannon sampling theorem)即 2sf B> (採樣頻率必須大於原類 比信號最高頻率的 2 倍),才能由採樣信號精確的重建原本信號。可見頻寬(BW)是對信號進行 採樣最基本的要求,但是對於 4G、5G 人們對頻寬的需求只增無減,以此為基礎傳統的信號 處理框架要求的採樣速率也越來越高,給硬體的即時處理帶來了極大的挑戰,解決這類問題 的方法就是信號壓縮,但是信號壓縮實際上是有資源浪費的,因為大量的冗餘(redundancy) 資料(較小係數)在壓縮過程中被丟棄,於是就很自然地產生了一個問題,原本是採樣那麼多丟 掉那麼多,那我們可不可以採樣少一點同時又可以完全恢復原本的類比信號? 在 2006 年壓縮 感知的概念被Donoho, Candes, and Tao正式提出。壓縮感知理論指出,只要信號x 是可壓縮的, 或是在某個變換域 Ψ 是稀疏的(sparse),那麼就可以用一個與變換基 Ψ 不相干(non-coherence) 的測量矩陣Φ(measurement matrix),將變換所得的高維信號投影到一個低維度空間上,然後 通過求解一個優化問題,就可以從這些少量的投影中以極高的機率重構出原本的信號。在壓 縮感知基礎框架中,採樣速率不再取決於信號的頻寬,而是在於信號的稀疏性(sparsity)和測 量矩陣的非相干性或稱信號的稀疏性和測量矩陣的有限等距性質(Restricted Isometry Property, RIP)。目前,壓縮感知理論主要涉及三大核心問題: 一、具有稀疏表示能力的過完備字典 =Θ ΦΨ (overcomplete dictionary, 即行數大於列數的矮胖型矩陣)的設計。二、滿足非相干性 或 RIP 性質的測量矩陣設計。三、快速且魯棒性(robustness)的信號重建演算法設計。壓縮感 知理論在許多領域都具有重要的影響,例如: 資料採樣,雷達成像,遙感成像,核磁共振成 像(MRI),無線傳感器網路(wireless sensor networks),source coding,人臉辨識,語音辨識, 機器學習低秩(low rank)分析…展開了廣泛的應用與研究,Rice University 更設計出了一種基於 壓縮感知的單像素相機。總而言之,壓縮感知利用了絕大部分信號所具有的一個基本特點, 在某個域是稀疏的或可壓縮的,而使得低於 Nyquist 頻率的採樣成為可能。 Fig1. Traditional sensing versus CS(compressive sensing).

- 2. 壓縮感知理論表達式 假設有一個信號在時域的表達為 ( )N ∈x x ℝ ,長度為 N,我們可以用變換域基底(或叫正交基底 或稀疏基底) ( 1,2,..., )i i N=Ψ 對信號 x 做展開 1 or . N i i i s = = =x Ψ x ΨS S 是信號 x 在 Ψ 域展開的係數向量。 假設 S 向量只有 K 個非零值( )K N≪ ,我們稱信號 x 在 Ψ 域下是稀疏的。壓縮感知理論告訴 我們,如果用一個與變換基 ( )N N×Ψ 不相干的測量矩陣 ( )M N×Φ 對 S 係數向量做線性變換, 所得到的測量集合 ( 1)M ×y ,那麼就可以利用優化求解方法從測量集合 y 中精確的重構出原本 的信號 x。 Fig2. Sparse representation in math. 基於壓縮感知的信號重構主要包含了三個步驟: (1) 如果信號 ( )N ∈x x ℝ 在某個正交基底 Ψ 是可壓縮的,求出展開的係數 1 T− = =S Ψ x Ψ x (2) 設計一個與正交基底 Ψ 不相干的測量矩陣 ( )M N×Φ ,對 S 進行觀測,得到測量集合 ( 1)M ×y or whereT CS CS T = = = =y ΦS ΦΨ x y A x A ΦΨ (3) 利用零範數(zero-norm)優化問題求解 x 的精確值或是使 ˆ →x x 0 min s.t.T CS T = =Ψ x A x ΦΨ x y

- 3. Fig3. Signal reconstruction based on CS. 所以就如同上節所表示的壓縮感知理論主要涉及三大核心問題: 一、對於 ( )N ∈x x ℝ 如何找到 某個正交基底 Ψ 使其在 Ψ 上表示是稀疏的。二、如何設計一個與正交基底 Ψ 不相干的測量矩 陣Φ,保證從 N 維降到 M 維( )M N≪ ,且重要的訊息資料不會遭受破壞。三、如何設計快 速重構演算法,從觀測 CS T = =y A x ΦΨ x 中恢復原本信號,即信號重構問題。 信號的稀疏表示 當信號 x 在正交基 Ψ 下的展開係數向量 T =S Ψ x時,假設0 2p< ≤ 和 0R > 這些係數滿足; 1/ p p ip i s R ≡ ≤ S 則係數向量 S 是稀疏的(我們通常取 p = 1 or 2),或者我們說信號 x 中非零係數的個數定義成 ( )0 x ,假設 0 dim( )x x≪ (x 的全部係數)成立,那我們說信號 x 是稀疏的。 而通常時域內的自然界信號都是非稀疏的,但在某些變換域內可能是稀疏的,例如: 一、在正交變換下,就是將信號投影至正交變換基底,若絕大部分正交變換下的係數取絕對 值很小或趨近零,那我們可以說在正交變換下信號是稀疏的。常見的正交變換基底有: 離散 餘弦變換(Discrete Cosine Transform, DCT),快速傅立葉變換(Fast Fourier Transform, FFT),離散 小波變換(Discrete Wavelet Transform, DWT),Gabor 變換…等,只有選擇適合的基底,才能保 證信號的稀疏性,進而保證信號恢復的精確度。 二、字典(dictionary),最近幾年對稀疏信號的另一個熱門研究就是信號在過完備字典 (overcomplete dictionary)下的稀疏分解,當一個信號含有多種模態時,用單一固定的正交基底 就不能完全實現信號的稀疏表示。字典實際上就是一個變換矩陣,矩陣的行向量稱為字典的 原子(atom),如果字典是 M N× 維變換矩陣Θ,那麼矩陣各行 ( 1,..., )i i N=θ 被稱為原子。而當 變換矩陣Θ 是方陣時,就是上述一所講的正交變換;當變換矩陣Θ 變成矮胖型矩陣時,則稱 為過完備字典,此時字典是行冗餘的。最早關於字典研究的重要文獻為Olshausen and Field[1], 他們從自然圖片中提取一些小 patch,通過這些 patch 生成能夠描述他們的基底,然後給定一 個 test patch,我們可以按照上面的式子通過正交基底 ( 1,2,..., )i i N=Ψ 對信號 test patch 做過完

- 4. 備字典基底展開線性組合得到,就如同機器學習中的稀疏編碼,目的就是找到一組基向量 iφ , 使得我們能將輸入 x 向量表示為這些基向量的線性組合 1 k i i i a φ = = x , 我們把有 m 個輸入向量的稀疏編碼的代價函數(cost function)定義為 ( ) 2 ( ) ( ) ( ) , 1 1 1 min ( )j i i m k k j j j i i i a j i i x a S a φ φ λ = = = − + 此處的 S(.)是一個稀疏代價函數,由 S 來對遠大於零的 ia 進行懲罰(penalty),使 x 的表達式變 稀疏。 這代表稀疏表示在挖掘複雜信號中未知特徵的能力。而現在熱門的機器學習訓練方法有 MOD[2],kSVD[3]等可以用各式各樣的信號源來產生有用的字典。 聯合稀疏信號 假設相同維數的一組信號 ( 1,..., )i i P=x 中每一個都是稀疏,且 ix 的非零元素(在某個字典或變 換下)位置都相同,我們稱為這組信號是聯合稀疏信號,而這個模型有點類似於 LASSO[4](Least Absolute Shrinkage and Selection Operator),同時進行特徵選擇和正規化(regularization)的回歸 分析(regression analysis)方法,目的在增強統計模型的預測準確性和可解釋性。聯合稀疏信號 恢復[5]應用層面很廣: 譬如多核機器學習[6],源定位[7],無線頻譜感知[8]等。 Fig4. Joint sparse signal CS or called MMV(Multiple Measurement Vectors) 低秩(low rank)矩陣分析 假設一個矩陣 , rank( ) min( , )m n r m n× ∈ =M Mℝ ≪ ,擁有 mn 個元素但只有 ( )r m n r+ − 個自由度 (考慮 M 的 SVD 奇異值分解, T =M UΣV 其中 , ,U Σ V 具有自由度 1 1 ( ), , ( ) r r i i m i r n i= = − − ),則 M 為低秩矩陣,其中低秩矩陣可用一個瘦長型矩陣和一個矮胖型矩陣來近似得到,低秩矩陣

- 5. 的恢復有著廣泛的應用[9-11],Netflix 推薦系統[12]等,我們也將著重於推薦系統的矩陣分解, 並推廣到多路張量,適用於更實際且廣泛的應用問題。 Fig4. Approximation of a low-rank matrix. 子空間聚類(Subspace Clustering)與 CS 的結合 這也將是我們明年的計畫重點之一。假設一個 k-sparse(k 稀疏度)的 n 維向量,他的非零元素 位置有 n kC 種可能,但在實際情況中,對於大多數信號而言,大部分的位置都是不太可能出現 的,譬如: 某些信號在某些正交變換後所得的係數滿足樹型結構,某些信號的非零係數位置 屬於聚類(cluster)結構,代表這些聚類信號必處於某個特定的線性子空間內,具有上述特徵的 信號往往更容易被恢復[13],而他們的結構特徵更容易由特定的子空間所產生[14,15]。 測量矩陣的設計方法 設計一個與正交基底 Ψ 不相干的測量矩陣Φ,保證從 N 維降到 M 維( )M N≪ ,且重要的訊 息資料不會遭受破壞,即從觀測 CS T = = =y A x ΦΨ x ΦS中恢復原本信號 x,且 S 為 K-sparse。 =y ΦS 也就變成一個常見的解線性方程組的問題, 1 1 , ,M N M N× × × ∈ ∈ ∈Φ y Sℝ ℝ ℝ 。 當一、 M N≥ 也就是方程式的數量大於等於未知數的個數時,我們可以用 LS(Least Squares) 最小平方法求最佳近似解,即 1 ( ) , ( ) is Hermitian operatorH H H LS − = ⋅S Φ Φ Φ y 當二、 M N< ,此方程組為 underdetermined system(欠定系統),一般而言有無窮多組解,但 是如果這個欠定系統有唯一一組稀疏解,則我們可以用壓縮感知的重構演算法來尋找這組 解。 而測量矩陣的有限等距性質(Restricted Isometry Property, RIP)給出了存在確定稀疏解的充要條 件。即對於滿足 1kδ < 的任何 K-sparse 向量 N ∈S ℝ ,如果對於最小的常數0 1kδ< < ,矩陣Φ滿 足 2 2 2 2 2 2 (1 ) (1 )k kδ δ− ≤ ≤ +S ΦS S 那麼稱矩陣Φ滿足 order K 的 RIP 條件。

- 6. 另外,測量矩陣基底 { }1,..., Nφ φ=Φ 與變換矩陣基底 { }1,..., Nψ ψ=Ψ 的相干性(coherence), ( , )µ Φ Ψ 定義為: 1 , 2 2 , ( , ) max i j i j N i j N φ ψ µ φ ψ≤ ≤ =Φ Ψ 這代表如果,測量矩陣基底 { }1,..., Nφ φ=Φ ,變換矩陣基底 { }1,..., Nψ ψ=Ψ 兩兩之間愈獨立, 相干性就愈低,精確重構所需要的觀測值個數 M 就愈少。 測量矩陣Φ的好壞會直接決定信號重構的性能,而目前常用於壓縮感知的測量矩陣有: 高斯 隨機矩陣 , ~ (0,1/ )i j N MΦ ,Bernoulli 矩陣,部分 Hadamard 矩陣,部分正交矩陣,Toeplitz 矩 陣,Circulant 矩陣…等,而一般大部分以高斯隨機矩陣作為測量矩陣。 稀疏信號重構演算法 壓縮感知重構演算法主要分為四大類: 一、凸優化算法,二、貪婪演算法,三、迭代演算法, 四、統計稀疏恢復算法。 Fig5. Summary of sparse recovery algorithms[16] 一、凸優化算法: 稀疏信號重構實質上是利用 M 維觀測向量 y 和測量矩陣 ( )M N×Φ ,採用一 定的演算法重構 N 維信號 x 的過程。我們考慮 Fig2.,則滿足 =y Φx 中最稀疏的向量就是所求 的解。故壓縮感知信號重構可表示成: 0 arg min s.t. =x y Φx

- 7. 但由於 N M≫ ,求解上式 0-範數(zero-norm)是個 NP-hard 的問題,需要 N KC 種取法才能驗證 非零元素的個數,所以上式無法直接求解,為了求最佳近似解,將上式 0-範數轉化為 1-範數 得到下式, 1 arg min s.t. =x y Φx Donoho 證明[17]上兩式是等價的,而 1-範數在數學上是一個凸優化問題,可以轉化為線性規 劃(Linear Programming, LP)加以求解,這種方法也稱為基追蹤(Basis Pursuit, BP): 我們可以用以 下的方法來求出 x 的最佳近似解 [ ] 1 2 1 2 0 0 0 0 BP min , s.t. , can transfer to LP LP min , s.t. , 0, where [1,1,...,1] , , , optimized optimized (1: ) ( 1: 2 ). N T T N N N N N × = ∈ = ≥ = ∈ = − = = − + x Φx y x c x Ax b x c x A Φ Φ b y x x x x ℝ ℝ Fig6. Geometry represent of 1ℓ recovery. 而實際應用中,信號 x 一定會遇到雜訊干擾,基追踪降噪法(Basis Pursuit De-Noising, BPDN), 與基追踪(BP)不同之處在於,BPDN 在模型中考慮到了雜訊的存在,我們假設 ,σ= + =y s z s Φx, x 是乾淨的信號,z 是高斯白雜訊(white Gaussian noise),σ 是雜訊量大小;而這在實際問題中 是非常有意義的。因為考慮到了雜訊。不同於 BP 的最優化模型可以轉化為線性規劃(LP)問題, BPDN 的最優化模型可以轉化為二次規劃(Quadratic Programming, QP)問題。

- 8. 2 2 2 1 2, 2 1 1 BPDN min , min ( ) , s.t. 0, 0. 2 2 where [1,1,...1] , can transfer to quadratic program. 1 QP min , s.t. 0 2 where , , N T T n n T n T T T n τ τ τ τ = − − + ∈ − − + + ≥ ≥ = + ≥ − = = = + x u vx u v z y Φx x x y A u v 1 u 1 v u v 1 z Bz c z z u z b A y c 1 v ℝ 0 0 0 0 , , 2log optimized optimized (1: ) ( 1: 2 ). T T T T N N N N τ σ − = = − = − + b A A A A B b A A A A z x z z 二、貪婪演算法 貪婪演算法通常在尋找下式的近似解,其基本思想就是在 sensing 矩陣Φ中,選擇最少行向量 個數去展延成 y,使其形成對 y 的近似表示,且兩個之間的誤差越小越好。 0 2 min s.t.N ε ∈ − ≤ x x y Φx ℝ 而最常用的演算法就是正交匹配追蹤(Orthogonal Matching Pursuit, OMP),其核心思想在於不 斷的在正交(Orthogonal)和匹配(Matching)之間進行迭代運算。 1 1,..., 1 , ,2 Matching : arg max , , Orthogonal: arg min , k k k j i j N i k S k LS k S k LS S r S S r φ− = = = = = − = = − x x y Φ x x y Φ x ∪ 其中 r 為殘餘量(residual), jφ 為 sensing 矩陣的第 j 行,通過匹配計算(找殘餘量與 sensing 矩 陣基底内積的最大值),就是逐步尋找與殘餘量最相關的 kS 基底,然後在當前關的 kS 基底下正 交投影求最小二乘估計 kx 。除了 OMP 外,也有許多 OMP 的推廣,例如: general Orthogonal Matching Pursuit (gOMP) OMP 每次只選擇與殘餘量相關最大的一個,而 gOMP 則是簡單地選擇最大的 S 個。 Compressive Sampling Matching Pursuit (CoSaMP) 每次迭代選擇多個原子,且每次迭代選擇的原子在下次迭代中可能會被拋棄。 Stagewise Orthogonal Matching Pursuit (StOMP) 每次迭代也可以選擇多個原子,此演算法的輸入參數中沒有信號稀疏度 K,因此相比於 ROMP 及 CoSaMP 有獨到的優勢。 Regularized Orthogonal Matching Pursuit (ROMP) 先選出內積絕對值最大的 k 行,然後再從這 k 行中按正則化標準再選擇一遍,即為本次迭代 選出的行向量,而 ROMP 每次迭代已經選擇的原子會一直保留。 於是我們可以比較各個演算法在(M = 128, N = 256)下在不同稀疏程度 K 的恢復率,gOMP 演算 法有不錯的表現。

- 9. Fig6. Compare the different sparse recovery greedy algorithms performance. 三、迭代演算法 此架構中的演算法包含 IHT (Iterative Hard Thresholding),與 AMP (Approximate Message Passing)。 IHT 核心思想[18]是以下式子, ( )( )1n n T n MH+ = + −x x Φ y Φx 即保留最大的 M 個元素,其他的都等於零,迭代到小於誤差值。IHT 算法對 sensing 矩陣Φ的 有限等距性質(RIP)有較高的要求。迭代演算法在近年來又衍生出 BP (Belief Propagation)[19]和 AMP (Approximate Message Passing)[20],AMP 演算法迭代如下 ( ) 1 where : threshold function, , : residual, / , ( ) ( ), / . Nt N t t t t ii M N s s u N s η δ η η = ∂ ′∈ = = = ∂ x z uℝ 由於 AMP 演算法與傳統 IHT 演算法相比多了一項 1 1 1 1 ( )T t t tη δ − − − ′ +A z x 所以性能更好,在 AMP 演算法基礎上得到的 GAMP(generalized AMP)可以很方便的擴展到 MMV(Multiple Measurement Vector)模型的稀疏重構[21],非負信號的稀疏重構[22],時變信號的動態壓縮感 知(Dynamic Compressive Sensing, DCS)[23]等多個應用領域,這也是我們接下來所要研究領域的 其中之一。但是 AMP 演算法與 IHT 演算法都有類似缺陷,即對 sensing 矩陣Φ的有限等距性 質(RIP)有較高的要求,限制了其在 DoA 方向估計,EEG/MEG,radar image 等領域的應用。 四、統計稀疏恢復算法

- 10. 我們將會把重點放在稀疏貝葉斯學習 SBL(Sparse Bayesian Learning),Micheal Tipping 首次提出 了稀疏貝葉斯學習(SBL)的概念,研究將一個函數用貝葉斯機率模型表示成多個基本函數的線 性疊加,它可以將信號和圖像等數據表示為一組基函數的線性組合,而它與支撐向量機(SVM) 都具有相同的核函數(kernel function)的形式,SBL 演算法基於分層貝葉斯模型(bayesian hierarchical),可以方便的描述信號的結構。之後 David Wipf 通過最大期望值 (Expectation-Maximization, EM)演算法,對後驗機率密度 ( );{ },ip γ βx y 和似然函數 ( ){ },ip γ βy 進行優化,實現稀疏信號的重構。同時 SBL 算法還具備 ARD(Automatic Relevance Determination)特性,即演算法通過迭代可自動確定待重構信號中非零元素的位置和大小,而 不用預先指定稀疏度 K;此外,當 sensing 矩陣Φ的行與行之間相關性較強時,絕大多數稀疏 重構算法甚至包括 AMP 算法性能都非常差,而 SBL 算法的性能卻能保持良好[24],此類算法 在應用中頗具優勢也是我們接下來所要研究領域的其中之一。而傳統的稀疏重構演算法如貪 婪演算法中的 OMP 類,具有較低的複雜度,但缺點就是需要給定稀疏信號的 K-sparse,雜訊 變異數等參數,但在實際應用中,這些參數往往不能預先得知,此外對 sensing 矩陣Φ的有限 等距性質(RIP)有較高的要求,傳統 SBL 類演算法缺點就是計算量大,如何建立快速且重構精 度高的稀疏信號演算法,並且 trade-off 各類優缺點,並應用在通訊問題上式我們接下來的重 點。 壓縮感知在通訊上面的應用 Fig7. Outline of subproblems of CS related to wireless communications and their examples.[16]

- 11. Fig8. Three promising technical directions for 5G.[26] 大規模天線(Massive MIMO)是 5G 發展的重點項目之一,因為相較於傳統的 MIMO 技術 Massive MIMO 有如下的優勢: 一、通信容量的大幅提升。Massive MIMO 具有波束空間複用 的特性,這使得在同頻率同 time slot 下,能夠利用地理位置的不同,實現與不同終端(UE)的 通訊,極大地提高了頻譜效率。二、覆蓋範圍與功耗的改善。理論上,通訊設備的功耗與其 覆蓋範圍成正比。當採用 Massive MIMO 技術時,由於其龐大的天線數量,增益大,相應的 RF 功耗能夠降低。三、降低終端計算複雜度 Massive MIMO 技術將計算複雜度高的運算過程 均放在基站(BS)處進行,因此大大地減 小了終端運算複雜度。目前,常用的信道估計算法大致可以分成以下三類: 一、盲信道估計, 二、基於參考信號(RS)的信道估計,以及介於兩者之間的三、半盲信道估計,這三類中,盲信 道估計無需導頻(pilot)序列輔助,而是利用調製信號本身固有的特徵來實現信道估計,所以計 算複雜度相對較高。基於參考信號的信道估計算法需要引入已知的導頻信號,並將其與傳輸 信號一同發送到接收端,由於該類算法過程中引入了額外的導頻序列,因此一定程度上影響 了無線通訊的頻譜利用率。其中應用最為廣泛的為最小二乘法(Least Squares, LS)和最小均方 誤差法(Minimum Mean Square Error, MMSE)。我們主要研究可基於壓縮感知和張量分解應用 在導頻的大規模 MIMO 通訊系統信道估計演算法(Channel estimation in massive MIMO)。

- 12. Fig9. Sparse domains and their applications in 5G.[25] 由於傳統信道估計算法如 LS,MMSE 重構精度低且消耗的大量導頻信號佔用頻寬資源,造成 了嚴重導頻污染,進一步影響了 Massive MIMO 系統性能。在時分多工(Time Division Duplexing, TDD)無線通訊系統中,上行信道和下行信道具有良好的互易性,所以對其下行信道狀態信息 的估計可以通過對上行信道矩陣進行轉置就可以獲得。但是在頻分多工(Frequency Division Duplexing, FDD)無線通訊系統中,其上行信道和下行信道並不具有互易性,系統無法承受龐大 的天線數目造成的巨大導頻開銷(因為導頻數目隨著發射天線數目增長而線性增長),因此在準 確地進行信道估計的同時減少導頻開銷及反饋負擔就成為了當前急需解決的問題。壓縮感知 可以應用在這方面的問題上。因為如 Fig9. 所示無線信道在某個域會表現出稀疏特性,且壓 縮感知能夠處理稀疏信號的重構,為解決上述導頻開銷大造成浪費的問題,已進行相關研究 中。 張量分解 張量分解的本質是希望能夠篩選出有意義的基,也就是子空間,從而使得數據在該子空間的 投影具有某種有意義的解釋,也正是如此,張量分解在數據挖掘、特徵提取等研究中受到了 廣泛的應用。對於張量分解,可以理解為矩陣分解向高維的拓展,也可以反向理解成對高維 張量數據的一種低秩逼近或特徵提取。目前常用的張量分解方法大多數都是基於 CP 分解和 Tucker 分解(又稱為 Higher-Order Singular Value Decomposition, HOSVD)。張量壓縮感知無需事 先知道信號稀疏性的前提仍能夠實現精確的重構,並且具有更高的重構精度。所以對張量壓 縮感知的改進和完善有著重要的研究意義。

- 13. Fig10. Canonical Polyadic decomposition (CP 分解) Fig11. Tucker decomposition (Tucker 分解) 稀疏貝葉斯學習(Sparse Bayesian learning, SBL) Wipf 和 Rao 等人對 SBL 進行了深入的理論研究。與廣泛使用的基於 L1 懲罰項的算法(比如 LASSO,Basis Pursuit)相比(以下簡稱 L1 算法),SBL 具有一系列顯著的優勢: (1) 在無噪情下,除非滿足一些嚴格的條件[Donoho2003],L1 算法的全局最小點(global minimum)並不是真正的最稀疏的解[Wipf2004]。因此,在一些應用中,當真實的解是最稀 疏的解,採用 SBL 是更好的選擇。 (2) 當感知矩陣(sensing matrix)的列與列相關性很強時,L1 算法的性能會變得非常差。事實上 不光是 L1 算法,絕大多數已知的壓縮感知算法(比如 AMP 近似消息傳遞算法,MP 匹配追 求算法)在這種情況下性能都會變得很差。相比之下,SBL 算法仍舊具有良好的性能 [Wipf_NIPS2011]。因此,在雷達追踪,波達方向估計,腦源定位,特徵提取,功率譜估計 等一些列領域,SBL 都具備顯著的優勢。 (3) 已證明,SBL算法等價於一種迭代加權L1最小化算法(iterative reweighted L1 minimization), 而 L1 算法僅僅只是其第一步[Wipf2010]。Candes 等人指出,迭代加權 L1 最小化算法更易 獲得真正的最稀疏解[Candes2008]。從這個角度也就不難理解 SBL 的優越性。 (4) 在很多實際問題中,所期望的稀疏解常常有一些結構,而利用這些結構可以獲得更好的性 [ModelCS]。作為一種貝葉斯算法,SBL算法對利用這些解的結構信息提供了更多的靈活性。 這種靈活性最主要來自於 SBL 採用參數化的高斯分佈為解的先驗分佈。 假設 CS 模型為 = +y Φx v, 1 1 sensing matrix , , , noise vectorM N M N× × × ∈ ∈ ∈Φ y x vℂ ℂ ℂ ,為了 求解 x,SBL 假設 x 中的每個元素都服從一個參數化的均值(mean)為 0 方差(variance)為 iγ 的高 斯分布,即 ( ; ) (0, ), 1,...,i i ip x N i Nγ γ= = 其中, ix 表示 x 中第 i 個元素,variance iγ 是未知的參數,由演算法自動估計出來,這樣一種 先驗分佈常被稱為 automatic relevance 自動相關先驗分佈,最初出現於人工神經網絡領域

- 14. [ARD1996]。在演算法運行中,絕大部分的 iγ 將會變成 0(無噪情況下)或者趨近於 0(有噪情況 下)。SBL 通常會採用一個閾值將趨近於 0 的 iγ 設置為 0(該閾值的大小通常和信噪比有關)。當 0iγ = 時,相應的 ix 則為 0。因此, iγ 與 x 解的稀疏程度密切相關,也從而決定了 iγ 的學習規 則是 SBL 算法中最核心的部分。而在 SBL 框架中,噪聲 v 通常假設為高斯白噪聲向量,即 ( ; ) (0, )p Nλ λ=v I 其中λ 為噪聲方差,根據以上的假設,利用貝葉斯公式很容易獲得後驗分佈,其也為一高斯 分佈,當所有的未知參數{ } 1 , N i i γ λ= 都被估計出來後,x 的最大後驗估計(Maximum A Posterior, MAP),由這個高斯分布的均值給出,而這些未知參數可以由第二類最大似然估計(Type II Maximum Likelihood)獲得。 Reference [1] B. A. Olshausen and D. J. Field, “Emergence of simple-cell receptive field properties by learning a sparse code for natural images,” Nature, vol. 381, no. 6583, pp. 607–609, 1996. [2] K. Engan, S. Aase, and J. Husoy, “Multi-frame compression: Theory and design,” Signal Processing, vol. 80, no. 10, pp. 2121–2140, Oct. 2000. [3] M. Aharon, M. Elad, and A. Bruckstein, “k-SVD: An algorithm for designing overcomplete dictionaries for sparse representation,” IEEE Transactions on Signal Processing, vol. 54, no. 11, pp. 4311–4322, Nov. 2006. [4] M. Yuan and Y. Lin, “Model selection and estimation in regression with grouped variables,” Journal of the Royal Statistical Society: Series B, vol. 68, no. 1, pp. 49–67, Apr. 2006. [5] J. Chen and X. Huo, “Theoretical results on sparse representations of multiple-measurement vectors,” IEEE Transactions on Signal Processing, vol. 54, no. 12, pp. 4634–4643, Dec. 2006.

- 15. [6] F. Bach, “Consistency of the group lasso and multiple kernel learning,” The Journal of Machine Learning Research, vol. 9, pp. 1179–1225, 2008. [7] D. Malioutov, M. Cetin, and A. Willsky, “A sparse signal reconstruction perspective for source localization with sensor arrays,” IEEE Transactions on Signal Processing, vol. 53, no. 8, pp. 3010– 3022, Aug. 2005. [8] J. Meng,W.Yin, H. Li, E.Hossain, and Z. Han, “Collaborative spectrumsensing from sparse observations in cognitive radio networks,” IEEE Journal on Selected Topics on Communications, special issue on Advances in Cognitive Radio Networking and Communications, vol. 29, no. 2, pp. 327–337, Feb. 2011. [9] M. Fazel, “Matrix rank minimization with applications,” Department of Electrical Engineering, Stanford University, Doctoral Thesis, 2002. [10] E. J. Cand`es and B. Recht, “Exact low-rank matrix completion via convex optimization,” in Proc. of IEEE Annual Allerton Conference on Communication, Control, and Computing, Monticello, IL, USA, September 2008, pp. 806–812. [11] B. Recht, M. Fazel, and P. Parrilo, “Guaranteed minimum-rank solutions of linear matrix equations via nuclear norm minimization,” SIAM Review, vol. 52, no. 3, pp. 471–501, 2010. [12] D. Goldberg, D. Nichols, B. Oki, and D. Terry, “Using collaborative filtering to weave an information tapestry,” Communications of the ACM, vol. 35, no. 12, pp. 61–70, 1992. [13] R. Baraniuk, V. Cevher, M. Duarte, and C. Hegde, “Model-based compressive sensing,” IEEE Transactions on Information Theory, vol. 56, no. 4, pp. 1982–2001, Apr. 2010. [14] Y. Eldar and M. Mishali, “Robust recovery of signals from a structured union of subspaces,” IEEE Transactions on Information Theory, vol. 55, no. 11, pp. 5302–5316, Nov. 2009. [15] Y. Lu and M. Do, “Sampling signals from a union of subspaces,” Signal Processing Magazine, IEEE, vol. 25, no. 2, pp. 41–47, Mar. 2008. [16] J. Choi et al., "Compressive Sensing for Wireless Communications: Useful Tips and Tricks", IEEE Commun. Survey and Tutorials, 2017. [17] S.S. Chen, D.L. Donoho, M.A. Saunders "Atomic decomposition by basis pursuit" SIAM review, 43, pp129-159, 2001. [18] Blumensath T, Davies M E. "Iterative hard thresholding for compressed sensing" Applied and Computational Harmonic Analysis., 27, 265–274, 2009. [19] S. Rangan, “Estimation with random linear mixing, belief propagation and compressed sensing,” in Proc. Conf. Inform. Science & Syst., (Princeton, NJ). IEEE, 2010, pp. 1–6. [20] M. Bayati and A. Montanari, “The dynamics of message passing on dense graphs, with applications to compressed sensing,” IEEE Trans. Inf. Theory, vol. 57, no. 2, pp. 764–785, Feb. 2011. [21] J. Ziniel and P. Schniter, "Efficient High-Dimensional Inference in the Multiple Measurement Vector Problem" IEEE Transactions on Signal Processing, vol. 61, no. 2, pp. 340-354, Jan. 2013. [22] J Ziniel, P Schniter "Dynamic compressive sensing of time-varying signals via approximate message passing" IEEE Transactions on Signal Processing 61 (21), 5270-5284, 2013. [23] Vila J, Schniter P. "An Empirical-Bayes Approach to Recovering Linearly Constrained Non-Negative Sparse Signals" IEEE Transactions on Signal Processing, 62(18) 4689–4703, 2014

- 16. [24] D. P. Wipf, "Sparse estimation with structured dictionaries", Proc. NIPS, pp. 2016-2024, 2011. [25] Z. Qin, J. Fan, Y. Liu, Y. Gao, and G. Y. Li, “Sparse representation for wireless communications: A compressive sensing approach,” IEEE Signal Process Mag., vol. 35, no. 3, pp. 40-58, May 2018. [26] Z. Gao, L. Dai, S. Han, I Chih-Lin, Z. Wang, and L Hanzo, “Compressive sensing techniques for next-generation wireless communications,” IEEE Wireless Communications, vol. 25 pp. 144-153, 2018 張量分解也可應用在推薦系統中,旨在通過分析用戶過去的模式向用戶提供個性化的推薦。 通過進一步使用用戶上下文數據(例如位置,時間,天氣,其他人的公司,環境氛圍,用戶活 動等)作為輔助信息,可以使建議更精確,但會導致更高維度的問題更難解決,計算要求更高 [3][4]。協同過濾[5] (Collaborative filtering)是許多現有推薦人的基礎系統。文獻中採用了兩種 主要方法,一種是最近鄰方法(nearest neighbor method)和另一個是潛在因子模型(latent factor model)(通常基於矩陣分解)。最近鄰方法基於用戶或項目的親密度的計算;潛在因子模型通過 一系列潛在因素來表徵項目和用戶來解釋評級。這些因子抓住用戶和項目的各種屬性或特徵, 並且通常可以通過分解用戶評級矩陣來提取[10]。由於其後者已被廣泛認為是更有效的模型在 2011 年 KDD 杯的 Netflix 獎競賽中成功應用。合併上下文數據,例如時間或位置,然後可以 將收集的評級置於多維張量中,並且潛在地因子也可以通過張量因子分解來提取。 矩陣和張量因子分解已被廣泛應用於各種信號中處理和機器學習應用[6],如信號源分離[7], 社交網絡分析[8],並用於學習潛變量模型[9]。我們將專注於在推薦系統中的協同過濾使用。 在文獻中,有兩個矩陣分解技術最多人采用,即交替最小二乘法(ALS)和隨機梯度下降(SGD) 方法[10]。每次迭代的 ALS 所需的時間複雜度是 2 3 (| | ( ) )O k m n kΩ + + ,Ω 是一組觀察到的評 級集合, k 是潛在因素的數量, m 是用戶數量, n 是項目數量,這是相當大的數目;但 SGD 的收斂速度可能非常慢,即便每次迭代的複雜度是 (| | )O kΩ 。為了實現分佈式異構數據庫的 協同過濾,有必要進行開發具有每次迭代複雜度較低的和較高的收斂速度的演算法。此外, 隨著添加對於上下文信息,還需要擴展這些方法以實現一般多路張量的分解。考慮多路張量 所涉及的高計算複雜性進一步激發了對來自學習者集合的分佈式計算和聚合的需求。 [3] G. Adomavicius, B. Mobasher, F. Ricci, and A. Tuzhilin, “Context-aware recommender systems,” AI Magazine, vol. 32, no. 3, pp. 67-80, 2011. [4] M. Kaminskas and F. Ricci, “Contextual music information retrieval and recommendation: State of the art and challenges,” Computer Science Review, vol. 6, no. 2-3, pp. 89-119, May 2012. [5] J. B. Schafer, D. Frankowski, J. Herlocker, and S. Sen, “Collaborative filtering recommender systems,” The Adaptive Web, Lecture Notes in Computer Science, vol. 4321, Editors: P. Brusilovsky, A. Kobsa, and W. Nejdl, Springer, Berlin, Heidelberg. [6] N. D. Sidiropoulos, L. De Lathauwer, X. Fu, K. Huang, E. E. Papalexakis and C. Faloutsos, “Tensor

- 17. decomposition for signal processing and machine learning,” IEEE Transactions on Signal Processing, vol. 65, no. 13, pp. 3551-3582, July, 2017. [7] D. Nion, K. N. Mokios, N. D. Sidiropoulos and A. Potamianos, “Batch and adaptive PARAFAC-based blind separation of convolutive speech mixtures,” IEEE Transactions on Audio, Speech, and Language Processing, vol. 18, no. 6, pp. 1193-1207, Aug. 2010. [8] M. Nakatsuji, Q. Zhang, X. Lu, B. Makni and J. A. Hendler, “Semantic social network analysis by cross-domain tensor factorization,” to appear in IEEE Transactions on Computational Social Systems, 2017. [9] A. Anandkumar, R. Ge, D. Hsu, S. M. Kakade, and M. Telgarsky, “Tensor decompositions for learning latent variable models,” J. Mach. Learn. Res. vol. 15, no. 1, pp. 2773-2832, January 2014. [10] Y. Koren, R. Bell and C. Volinsky, “Matrix factorization techniques for recommender systems,” Computer, vol. 42, no. 8, pp. 30-37, Aug. 2009. Written by Jay Chang 2018/10/10